|

| class | Adam |

| | Optimizador Adam (Adaptive Moment Estimation). Combina momentum y RMSProp para un aprendizaje más estable y rápido. More...

|

| class | BCELoss |

| | Función de pérdida Binary Cross Entropy (entropía cruzada binaria). Usada típicamente en clasificación binaria. More...

|

| struct | BSpline |

| class | CrossEntropyLoss |

| | Función de pérdida Cross Entropy para clasificación multiclase. Requiere que las etiquetas verdaderas estén codificadas one-hot. More...

|

| class | Dense |

| struct | ILayer |

| | Interfaz para una capa de la red neuronal. Permite que distintas capas se conecten entre sí con polimorfismo. More...

|

| struct | ILoss |

| | Interfaz para una función de pérdida (loss). Se encarga de calcular qué tan mal lo hizo la red con respecto a los resultados reales y obtener el gradiente necesario para ajustar los parámetros. More...

|

| struct | IOptimizer |

| | Interfaz para definir un optimizador (ej. SGD, Adam, ...). Un optimizador se encarga de actualizar los parámetros entrenables (como pesos y biases) en base a los gradientes. More...

|

| class | Kan |

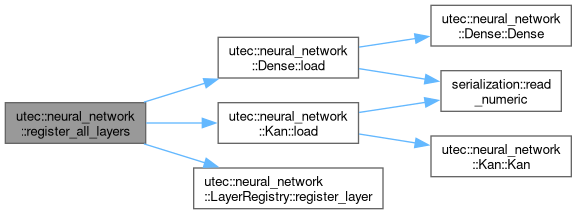

| class | LayerRegistry |

| | Registro de tipos de capas para deserialización. More...

|

| class | MSELoss |

| | Función de pérdida MSE (Error Cuadrático Medio). Mide el promedio de los cuadrados de las diferencias entre las predicciones y los valores reales. Es común en tareas de regresión. More...

|

| class | NeuralNetwork |

| | Clase que representa una red neuronal completamente conectada. More...

|

| class | ReLU |

| class | SGD |

| | Optimizador Stochastic Gradient Descent (SGD). Actualiza los parámetros en dirección opuesta al gradiente multiplicado por el learning rate. More...

|

| class | Sigmoid |

| | Capa de activación Sigmoid. Convierte cada valor en el rango (0, 1) abierto usando la función logística. No tiene parámetros entrenables. More...

|

| class | Softmax |

| | Capa de activación Softmax. Convierte un vector de valores en probabilidades las cualesal ser sumadas resultan en 1. Se aplica por fila (una muestra a la vez). No tiene parámetros entrenables. More...

|

Capa de activación de Rectified Linear Unit (ReLU). Los valores negativos del input se convierten en 0. Los valores no negativos permanecen igual.

Capa totalmente conectada (o Dense Layer) de una red neuronal. Cada neurona de esta capa se conecta con todas las salidas de la capa anterior. Esta capa tiene pesos y biases como parámetros entrenables.

- Template Parameters

-

| T | Tipo de dato (usualmente float o double). |